Grün, Rot und Blau sind die gängigen Farbfilter, die das Pixelarray überziehen und andere Farben herausfiltern. Da jeder Pixel nur den Wert eines Farbkanals aufnehmen kann, ist noch eine recht aufwändige Nachbearbeitung, die sogenannte Interpolation, notwendig. Thomas Ußmüller arbeitet in Kooperation mit der Friedrich-Alexander-Universität Nürnberg an einer Pixelstruktur, in der alle Farbinformationen in einem Pixel, dem kleinsten Element eines digitalen Bildes, ausgelesen werden können. „Ein digitaler Bildsensor ist eine Vorrichtung, die ein optisches Bild in elektrische Signale umwandelt und ein Sensorarray ist aus einem zweidimensionalen Pixelarray aufgebaut“, erläutert Ußmüller, der weiters ausführt, dass die Hälfte der Pixel mit dem Farbfilter Grün überzogen sind und jeweils ein Viertel mit Rot und Blau. Der größere Grün-Anteil kann auf die höhere Empfindlichkeit der Augen in diesem Spektralbereich zurückgeführt werden. „Steht auf einer Kamera, dass sie mit einer Auflösung von 20 Megapixel fotografiert, dann entspricht dies 10 Millionen grünen Farbpixeln und jeweils 5 Millionen roten und blauen“, so der Wissenschaftler, der vertieft, dass das bisherige Problem darin besteht, dass jeder Pixel nur eine Farbinformation auslesen kann. „Vor allem bei scharfen Kanten von fotografierten Gebäuden wird sichtbar, dass trotz aufwändiger Interpolation nicht deutlich wird, wo die Farbe der Gebäudekante endet. Dies zeigt sich vor allem in großer Vergrößerung des Bildes in unklaren Kanten“, so Ußmüller.

Konzentrische Pixel

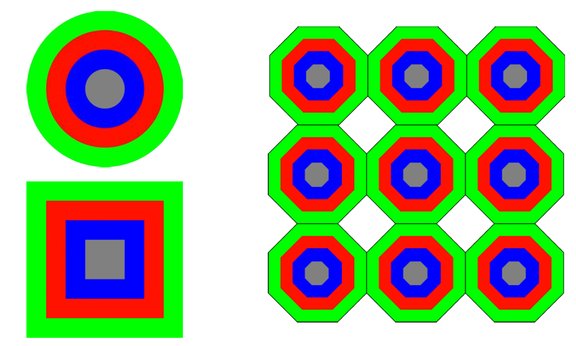

Um diese Unschärfe zu verhindern, schlägt der Wissenschaftler eine konzentrische Pixelstruktur vor. Dabei soll ein Pixel nicht nur eine Farbinformation, sondern die Informationen von Grün, Rot und Blau und bei Bedarf zusätzlich mit einer Helligkeitsinformation transportieren. Mit diesem Verfahren würde auch die Interpolation, die bisher bei jedem normalen Bildsensor notwendig war, entfallen. „Mit Hilfe dieser Erfindung ist es möglich, Pixel und Farbfilter neu anzuordnen und so effizientere Farbbildsensoren zu entwerfen. Dazu enthält jeder Pixel nicht nur eine, sondern mindestens drei Fotodioden, die von der gleichen Anzahl Farbfilter abgedeckt sind“, erläutert der Experte für Mikroelektronik. Mit der von Ußmüller patentierten Erfindung kann jeder einzelne Pixel drei Farbinformationen liefern, wodurch die Bildqualität deutlich verbessert wird. Besonders im Bereich der Kanten wird eine enorme Verbesserung der Qualität sichtbar. Wo genau die neuen Bildsensoren eingesetzt werden, ist jedoch noch unklar, obwohl mehrere Anwendungsbereiche denkbar sind. „Die verbesserte Schärfe ist natürlich auch für Fotos von Vorteil. Besonders relevant wird die neue Technik aber im Bereich von autonomen Fahrzeugen, die Objekte genau erkennen müssen. Hier ist die Kantenerkennung für viele Algorithmen wichtig. Weitere Anwendungsbereiche könnten auch die industrielle oder wissenschaftliche Bildverarbeitung sein“, so Ußmüller.