I Sprache

Am 8. März 2023 veröffentlichte Noam Chomsky, der die Linguistik der zweiten Hälfte des 20. Jahrhunderts wie wohl niemand sonst prägte, in der New York Times einen Artikel mit dem Titel „The False Promise of ChatGPT“. Darin formuliert er seine Befürchtung, AIs wie beispielsweise ChatGPT entwerteten unsere Wissenschaft und entwürdigten unsere Ethik, indem sie eine grundlegend falsche Auffassung von Sprache und Wissen in unsere Technologie einschrieben. Woher diese scharfe Verdammung? Folgt man dieser Frage, stößt man darauf, dass ChatGPT hier in eine langjährige Forschungsdiskussion zur Modellierung von Sprachkompetenz eingreift.

Denn Chomsky beteiligte sich seit den 1960ern an Projekten, die Kommunikation mit Computern in natürlicher Sprache ermöglichen sollten. Mit seiner Theorie der generativen Grammatik geht Chomsky davon aus, dass komplexe abstrakte Prinzipien für natürliche Sprachen angeboren sind und es Kindern ermöglichen, die spezifischen Regeln ihrer jeweiligen Sprache schnell zu erlernen. Entsprechend verfolgte er den Ansatz, diese Regeln in Programme umzusetzen, um Computern natürliche Sprache beizubringen.

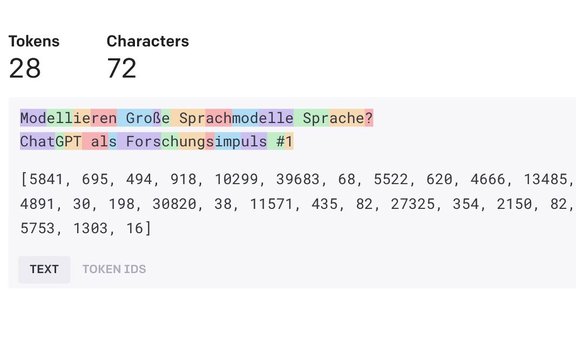

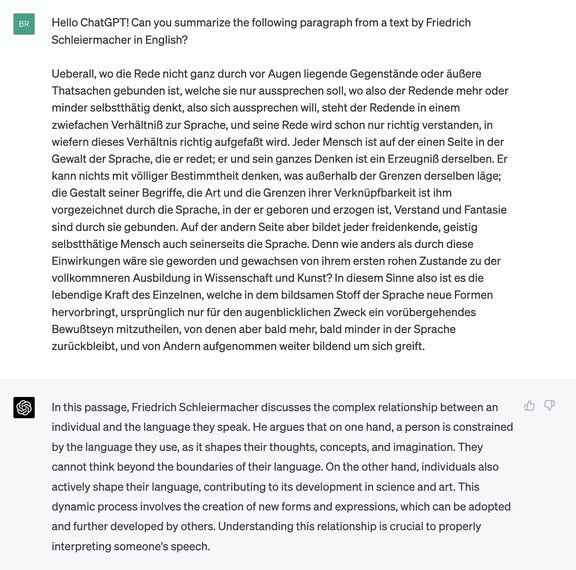

Wie wir allerdings momentan miterleben, führte eine völlig andere Herangehensweise zum Durchbruch: Für sogenannte Große Sprachmodelle (Large Language Models) wie ChatGPT wird ein maschineller Lernprozess ausschließlich mit enorm vielen Texten daraufhin trainiert, für eine gegebene Folge ein wahrscheinliches nächstes Wort (oder genauer: ein sogenanntes Token, eine Gruppe weniger Zeichen) zu finden. Große Sprachmodelle funktionieren also auf der Basis induktiv erschlossener Häufigkeit, nicht durch explizit formulierte Regeln. ChatGPT ist in der Lage, auf Eingaben in mehreren Sprachen mit beeindruckender Geläufigkeit und häufig sehr sinnvoll zu reagieren. Insbesondere beim Umformulieren von Texten zwischen komplexen und einfachen, formalen, informellen und dialektalen Registern, beim Zusammenfassen längerer Texte wie umgekehrt beim Ausformulieren von Stichpunkten liefert ChatGPT meist gut brauchbare Ergebnisse.

Die Korpuslinguistik, die sich seit den späten 1990ern darauf konzentriert, tatsächlichen Sprachgebrauch durch die Beobachtung von Häufigkeiten in großen Textsammlungen zu beschreiben und an vielen Linguistik-Instituten die Rolle der generative Grammatik zurückdrängte, kann sich von diesem Erfolg im Umgang von Computern mit natürlicher Sprache – der sich durch den Qualitätssprung von maschineller Übersetzung mit Programmen wie DeepL, die auf ähnlichen Modellen basieren, bereits leise abzeichnete – potentiell bestätigt sehen. Und so verwundert die Heftigkeit von Noam Chomskys Reaktion auf ChatGPT nicht: Er verteidigt hier seine Kernansichten darüber, wie die menschliche Fähigkeit zur Produktion von Sprache beschaffen ist.

Offensichtlich bedeutet das erfolgreiche Produzieren von Äußerungen in natürlicher Sprache durch ChatGPT nicht, dass menschliche Sprachproduktion genauso abläuft: Beispielsweise sind Menschen nicht beschränkt auf ChatGPTs strikt lineare Produktion von je einem Token nach dem anderen; sie können das Ende eines Satzes vorausplanen. Wir können also die Funktionsweise von Sprachmodellen nicht einfach auf Prozesse menschlicher Sprachproduktion übertragen. Doch Große Sprachmodelle wie ChatGPT zeigen, dass ein erfolgreicher Umgang mit natürlicher Sprache auch durch erschlossene Häufigkeiten modelliert werden kann, und dieser empirische Befund liefert einen wichtigen Impuls zu dieser hochprofilierten Forschungsdiskussion in der Linguistik.

II Sprachen?

Vor diesem Hintergrund möchte ich anregen, Große Sprachmodelle auch in eine andere Forschungsdiskussion einzubringen, nämlich zu Mehrsprachigkeit. Denn ChatGPT geht mit Eingaben in verschiedenen Sprachen, Dialekten und Registern souverän um und wechselt je nach Bedarf in der Sprachproduktion zwischen ihnen hin und her. ChatGPT ist also mehrsprachig.

Wie lässt sich Mehrsprachigkeit konzeptuell fassen? Eine weit verbreitete Vorstellung basiert auf der Annahme, Einsprachigkeit sei der Regelfall, bezogen auf Menschen wie auf Texte. Ausgehend von einer Sprache als gedanklicher Einheit besteht Mehrsprachigkeit dann entsprechend aus der Addition von Einzelsprachen: eine Sprache und noch eine und noch eine. Demgegenüber gibt es die Position, man könne Sprachen nicht kategorisch voneinander scheiden, sondern das, was man üblicherweise als eine Sprache bezeichnet, gehe immer über in das, was dann eine andere Sprache wäre.

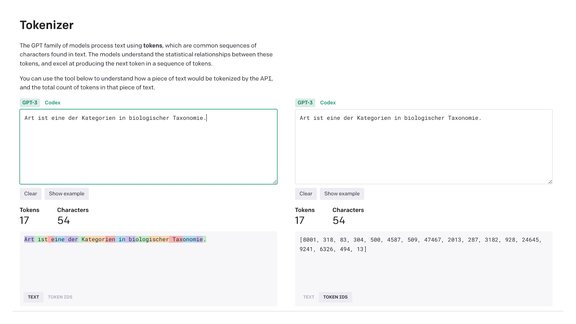

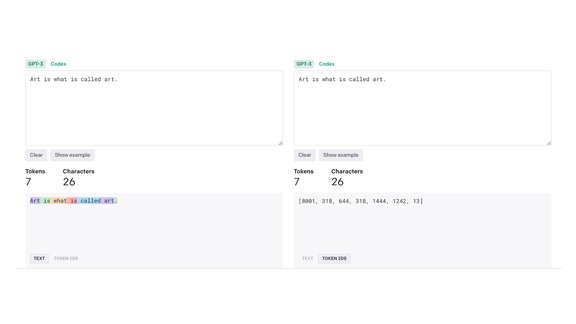

Wie verhält sich ChatGPT dazu? Das Modell unterscheidet zunächst nicht zwischen verschiedenen Sprachen; weder die Trainingsdaten noch die Architektur geben eine entsprechende Kategorisierung vor. ChatGPT kennt in einem einzigen großen Modell die Wahrscheinlichkeiten für die individuellen Verknüpfungen von enorm vielen kurzen Zeichenfolgen, sogenannte „Token“, ohne Vorwissen dazu, zu welchen Sprachen sie gehören. Zur Verarbeitung wird der Eingabetext in diese Token zerlegt, die dann jeweils durch eine Zahl repräsentiert werden, mit der das Modell rechnet. Die Zeichengruppe „Art “ beispielsweise wird durch die Zahl „8001“ repräsentiert, egal, ob sie in dem Satz „Art is what is called art.“ oder in dem Satz „Art ist eine Kategorie in der biologischen Taxonomie.“ vorkommt.

Wie kann es sein, dass ChatGPT dennoch auf deutschsprachige Eingaben auf Deutsch, auf englischsprachige Eingaben auf Englisch reagiert? Das liegt daran, dass ein Wort sehr viel häufiger im Kontext von Worten der gleichen Sprache zu finden ist: „Nacht“ in der Nähe beispielsweise von „Himmel“ und „Sternen“, „night“ bei „sky“ und „stars“ – aber, wie dieses Beispiel sofort zeigt, eben nicht nur, denn in diesem Satz steht nun „night“ neben „bei“ und „und“ neben „sky“. Und so modellieren Große Sprachmodelle eben auch diese Verbindungen, die man als Ausnahmefälle betrachtete und als solche ignorierte, ginge man von einer Vorstellung aus, die Einzelsprachen als voneinander klar getrennt betrachtet. Weil aber Wörter aus „verschiedenen Sprachen“ in der Praxis eben doch nebeneinander stehen, finden diese Verbindungen Eingang in die vielen Milliarden Wahrscheinlichkeitsbeziehungen von ChatGPT, genauso wie Verbindungen zu Dialektausdrücken, zu seltenen oder inzwischen selten gewordenen Worten, zu Slang, zu Metaphern – eben zu überhaupt allen Worten, aus denen unsere Äußerungen bestehen. ChatGPT macht keine kategorischen Unterschiede, schließt nichts bereits vorab als nicht zugehörig aus, sondern greift für die Gewichtungen der Wahrscheinlichkeiten auf das gesamte Repertoire zurück, das da ist. Genau das, vermute ich, könnte der Grund sein, warum ChatGPT so erfolgreich Äußerungen zwischen Registern und Sprachen umformuliert: Die Wörter einer jeweiligen wahrgenommenen „Einheit“ sind zwar mit höheren Wahrscheinlichkeitswerten verknüpft, aber die Verbindungen zu allen anderen Wörtern sind ebenso mitbestimmt und daher nutzbar. Und das ermutigt, so denke ich, doch dazu, probeweise in Überlegungen auch zu menschlicher Sprachfähigkeit nicht von kategorialen Trennungen auszugehen, sondern alle Sprachkenntnisse als ein vielfach vernetztes sprachliches Repertoire zu verstehen, das genau durch seine Verbindungen Differenzierung und Gewandtheit ermöglicht.

(Brigitte Rath)

Biografische Notiz

Brigitte Rath lehrt und forscht am Institut für Vergleichende Literaturwissenschaft an der Universität Innsbruck. Sie ist Co-Organisatorin des Kolloquiums Mehrsprachigkeit sowie Mitglied im Forschungszentrum Digital Humanities.

Kommentare

[19.04.2023] "Sehr guter Diskussionsbeitrag! Die Token-Erzeugung bei Chat-GPT und anderen Transformer-basierten Programmen ist übrigens, anders als in Recurrent Neural Networks, nicht vollkommen linear. Hier eine gute Einführung in das Verfahren: https://www.youtube.com/watch?v=SZorAJ4I-sA" (Johannes Hoff)